Von ChatGPT bis Llama: Der Status quo und die Zukunft von generativer KI

Künstliche Intelligenz ist gekommen, um zu bleiben. Spätestens seit dem Launch von ChatGPT im November 2022 ist den meisten klar: Das Potenzial von generativen KI-Modellen ist riesig und bietet der Wirtschaft unzählige Chancen, um Herausforderungen wie den Fachkräftemangel zu bewältigen oder die eigene Effizienz zu steigern.

Wir werfen in diesem Artikel einen Blick auf den Status quo und die Zukunft von Generative AI: Wie sind wir so weit gekommen und wie werden sich die verschiedenen Modelle höchstwahrscheinlich weiterentwickeln.

ChatGPT – Wie sind wir so weit gekommen?

Die Weiterentwicklung von Large Language Models (LLM) ging rasant – und hat selbst Expert:innen verblüfft. Noch im Dezember 2022 glaubte selbst ein renommierter KI-Experte, GPT-4 „won’t be very useful, and won’t see much practical use“.

Er hat sich getäuscht.

Der Launch von ChatGPT hat eine Welle ins Rollen gebracht. Mit einem Mal brachten LLMs Nutzenden einen echten, spürbaren Mehrwert.

Die Gründe dafür lassen sich vereinfacht auf drei Aspekte herunterbrechen.

1. Mehr Daten und Computing-Power

Open AI hat ChatGPT-4 mit einem noch größeren Set an Daten und mehr Computing Power trainiert als das Vorgängermodell. Das heißt, die aktuelle Version verfügt über einen breiteren Wissensschatz und wirkt allein deswegen schlauer.

2. Instruct Finetuning und Reinforcement Learning from Human Feedback als zusätzliche Trainingsmethoden

Die spürbar höhere Intelligenz beruht auch auf der Weiterentwicklung durch neue Trainingsmethoden. Neben der reinen Skalierung des Models anhand von einem größeren Datensatz haben die Entwickelnden auch auf Instruct Finetuning und Reinforcement Learning from Human Feedback gesetzt.

Instruct Finetuning

Instruct Finetuning ist ein Trainingsansatz für große Sprachmodelle. Das Ziel: die Feinabstimmung von vortrainierten Modellen. Dabei wird das Modell darauf trainiert, Instruktionen zu folgen und so Aufgaben des Nutzenden zu erfüllen, statt einfach Text fortzusetzen.

Dieser Ansatz schließt die Lücke zwischen allgemeinem Sprachverständnis und spezifischer Aufgabenerfüllung. Das Ergebnis: Das Modell ist anpassungsfähiger und präziser bei verschiedenen Aufgaben.

Reinforcement Learning from Human Feedback

Bei dieser Methode handelt es sich um einen iterativen Prozess. Dabei bewerten Menschen den Output, den Machine-Learning-Modelle generieren in „gut“ oder „schlecht“. Dieses menschliche Feedback lenkt den Lernprozess des Modells und verbessert so die Entscheidungsfindung. Diese Methode schließt die Lücke zwischen menschlichem Fachwissen und maschinellen Lernalgorithmen. Auf diese Weise wird das Modell dazu gebracht, bestimmten („verbotenen“) Output nicht mehr zu generieren.

Beide Ansätze helfen den Modellen, flexibler auf Anweisungen zu reagieren und noch spezifischeren Output zu generieren. Außerdem: Diese Trainingsmethoden sind wesentlich kosteneffizienter als das Training mit noch größeren Datenmengen.

"Erstmals ist KI für fast jede Person einfach zugänglich."

3. ChatGPT ist barrierearm zugänglich

ChatGPT ist fast für jede Person zugänglich und intuitiv bedienbar. Denn: ChatGPT ist als Chat konzipiert – dieses Format ist den allermeisten durch andere Alltagsanwendungen und Messenger-Dienste bekannt. Außerdem lindert das Chat-Format etwaige Schwächen der Modelle ab. Dadurch, dass immer eine Person involviert ist, können Missverständnisse oder auch Fehler mit der “Maschine” schnell relativiert werden.

Ein weiterer Erfolgsfaktor: ChatGPT von Open AI ist frei zugänglich und braucht nicht aufwendig per Schnittstelle – ergo Coding – in bestehende Systeme integriert werden. Das heißt: Erstmals ist KI für (fast) jede Person einfach zugänglich.

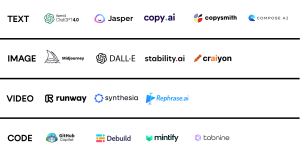

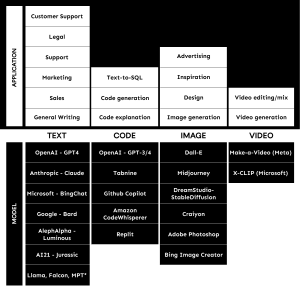

Marktübersicht: Diese Modelle und Anbietenden gibt es

ChatGPT von OpenAI mag aktuell die bekannteste KI-Anwendung sein. Es gibt jedoch mittlerweile viele weitere von ähnlicher Qualität. Die Einsatzgebiete sind dabei vielfältig. Sie reichen von LLMs für Suche und bspw. Textgenerierung (ChatGPT, Google (Bard), Microsoft (BingChat), Antrophic (Claude) über Modelle zur Bildgenerierung (bspw. wie StableDiffusion, Midjourney) über Customer Care (Fin (Intercom), QMQ (basieren beide auf GPT-4), den Legal-Bereich (Harvey (basiert auf GPT-4)) bis hin zu Modellen, die beim Coden unterstützen (bspw. GitHub Copilot, Replit).

Mit unseren KI-Expert:innen haben wir eine – nicht vollständige – Übersicht zusammengestellt über Modelle und deren Anwendungsbereiche.

* Open Source Modelle

What’s next?

Wir haben unserem KI-Experten Dr. Philipp Bongartz die Frage gestellt: Wie geht es weiter mit dem Thema generative KI? Werden wir weiter eine Phase der massiven Skalierung sehen oder wie werden die existierenden Modelle in der nahen Zukunft weiterentwickelt.

Ein Tech Deep Dive

Er sieht im Wesentlichen zwei Schwerpunkte für die Weiterentwicklung von Modellen. Zum einen geht er davon aus, dass die Bedeutung von Open Source zunehmen wird. Zum anderen werden wir verstärkt Techniken zum Finetunen der Modelle sehen, die sich ebenfalls stetig weiterentwickeln.

Konkret heißt das laut Philipp:

1. Open Source ermöglicht schnellere Anpassung von Modellen

Im August 2022 wurde das Modell hinter Stable Diffusion veröffentlicht. Damit explodierten die Entwicklungen im Bereich der Bildgeneration. Technische Neuerungen aus der Forschung konnten schnell in User Inferfaces integriert und tausenden von Nutzern zugänglich gemacht werden.

Normalerweise fehlt diese Verbindung von wissenschaftlichen Papern zu den Nutzenden, weil die Modelle nicht öffentlich zugänglich sind. Aber genau diese Verbindung ist eine gute Möglichkeit, den Status quo zu challengen. Gerade Google ist bekannt dafür spannende Forschungsergebnisse zu produzieren, die dann aber nie in einem Produkt münden.

Durch die Veröffentlichung des Quellcodes von Modellen auf Open-Source-Plattformen ändert sich das. Unternehmen können diesen plötzlich vergleichsweise einfach für kommerzielle Apps nutzen und adaptieren. Über diesen Weg erhalten auch nicht-technische Nutzende Zugriff auf erprobte Techniken.

Ein Beispiel: Lensa ermöglicht es Millionen von Usern, Bilder von sich selbst in verschiedensten Looks und Situationen zu generieren. Die Anwendung basiert auf einer Technik namens Dreambooth, die von Google entwickelt und kurz zuvor für Stable Diffusion adaptiert wurde.

Lange war unklar, ob solche Praktiken auch bei LLMs zu sehen sein würden. Denn: Diese Modelle sind wesentlich größer und liefen nur auf spezialisierter Hardware. Mit den Modellen Llama 7B, 13B, 30B, 65B veröffentlichte Meta dann jedoch eine Reihe sehr leistungsfähiger Modelle. Diese sind öffentlich zugänglich, jedoch streng genommen nicht Open Source.

Gleichzeitig gibt es zwei technische Entwicklungen, die es auch Nutzenden mit normaler Hardware ohne riesige Rechen-Power erlaubt, diese Modelle laufen zu lassen. Modelle werden jetzt quantisiert, d.h. die Auflösung einzelner Parameter der Modelle wird verringert, wodurch der RAM-Verbrauch stark sinkt. Die Qualität bleibt jedoch nahezu gleich. Außerdem wurden die Modelle zu CPUs portiert – auch auf Apple-Rechnern laufen Llama-Modelle überraschend schnell und eine externe GPU ist nicht mehr notwendig.

ChatGPT und Llama als Open-Source-Repliken in Arbeit

Eine Reihe von Organisationen haben es sich zum Ziel gesetzt, Llama oder ChatGPT Open Source zu replizieren. Schon jetzt werden regelmäßig neue, leistungsfähige Open-Source-Modelle veröffentlicht.

Open Source ist ein großer Schritt für die Entwicklung und Verbreitung von Anwendungen basierend auf generativer KI: Es erhöht die Zugänglichkeit zu Modellen drastisch, erlaubt einen deutlich höheren Stamm von Nutzenden und entfacht so eine ganz neue Dynamik. Außerdem gibt es direktes Feedback, sodass Modelle schnell angepasst, verbessert und gegebenenfalls sogar kommerzialisiert werden können.

Finetuning von Modellen

Ein weiterer Treiber der Open-Source-Modelle sind neue Techniken, um Modelle relativ kostengünstig auf neue Daten zu tunen.

Dazu gehören zum Beispiel Dreambooth (weiter oben erwähnt) oder LoRA. LoRA ist eine Technik, die dem Modell wenige Parameter hinzufügt und diese dann tunt. Das ist sehr kostengünstig und beinahe ebenso gut, wie das gesamte Modell zu tunen. Das Besondere: LoRAs lassen sich kombinieren. Es lassen sich folglich eine Reihe bestimmter Fähigkeiten zu einem Modell hinzufügen.

Neben diesen Techniken ist es möglich geworden, Modelle zu vereinen. D.h. ähnlich wie LoRAs lassen sich auch vollständig getunte Modelle kombinieren, um die Fähigkeiten beider Modelle zu verbinden.

Finetuning ermöglicht Anpassung an spezielle Use Cases

Diese beiden Techniken ermöglichen es Data Scientists, Modelle mit sehr geringem Budget und in kollektiver Arbeit immer weiter zu verbessern und sehr genau auf bestimmte Use Cases anzupassen. Eine große Chance für Unternehmen und die Wirtschaft.

Auf Phase der massiven Skalierung folgt Spezialisierung

Wir haben in den letzten Jahren eine Phase der massiven Skalierung beobachtet. Modelle wurden mit immer mehr Daten und Compute trainiert. Das Ergebnis: Bei aktuellen Modellen haben Nutzende erstmals das Gefühl, mit einem in gewisser Weise intelligenten Wesen zu tun zu haben.

Mit großer Wahrscheinlichkeit folgt auf diese Phase der Skalierung nun eine Phase der Spezialisierung. Dafür sprechen die Vorgehen und Techniken, die Expert:innen aktuell schon bei OpenAI und Co beobachten. Auf diese Weise können verschiedene Modalitäten in bestehende Modelle integriert werden (bspw. Bilder oder Videos).

Für das Abklingen der Skalierungswelle spricht auch die Tatsache, dass nun eine wesentlich größere Menge an Nutzenden mit den existierenden Modellen arbeitet und testet. Das erlaubt es, herauszufinden, welche Fähigkeiten und Use Cases die wertvollsten sind. Für diese können dann spezialisierte Modelle trainiert oder getunt werden.

Ein Beispiel: Harvey ist eine Anwendung, die auf GPT-4 basiert und auf Gesetzestexte spezialisiert ist. Solche hochspezialisierten Anwendungen für bestimmte Bereiche – sei es Predictive Maintanance, Customer Care oder Financial Service – werden wir in Zukunft deutlich mehr sehen.

GPT-5: Wann und was erwartet uns?

Es spricht vieles dafür, dass GPT-5 noch mindestens zwei Jahre auf sich warten lässt. Zwischen GPT-3 und GPT-4 lagen drei Jahre. Es ist unwahrscheinlich, dass OpenAI GPT-5 direkt im Anschluss an GPT-4 trainiert.

Es ergibt Sinn, erst ein verbessertes Verständnis der Use Case zu erlangen, Algorithmen zu verbessen und größere, multimodale Datensätze zu generieren, bevor das Unternehmen ein komplett neues und möglicherweise deutlich größeres Modell trainiert. Denn: Schon die Entwicklung GPT-4 hat (angeblich) 63 Millionen Dollar gekostet. Ein noch größeres Modell zu trainieren, würde diese Summe vermutlich übersteigen. Je länger sie warten, desto besser ist ihr Verständnis von den Needs der Nutzenden und desto besser können spezielle Use Cases berücksichtigt und der Status quo verbessert werden.

Aber eins ist sicher: Neue Modalitäten werden kommen. Entweder in aktuelle Modelle integriert oder anhand komplett neu aufgesetzter Modelle.

Generative KI und ihre Bedeutung für die Wirtschaft

Die aktuellen Entwicklungen bergen großes Potenzial für die Wirtschaft. Schon jetzt berichten Nutzende von ChatGPT und Co von großen Effizienzsprüngen. Mitarbeitende erstellen mühelos erste Textentwürfe, lassen Code schreiben und prüfen oder recherchieren aufwendige Themen in kürzester Zeit. Noch fließt Aufwand in die Überarbeitung des Outputs – aber trotzdem können Mitarbeitende in bestimmten Bereichen schon jetzt spürbar Zeit sparen.

Um die Effizienz durch die Unterstützung von generativer KI weiter steigern zu können durch die Unterstützung von generativer KI wird die jetzt einsetzende Spezialisierung und Verfeinerung von Modellen hochrelevant sein. Denn: Perspektivisch hoffen Unternehmen darauf, sehr spezialisierte Use Cases mit der Unterstützung von AI-Anwendungen zu automatisieren.

Um dieses Szenario möglich zu machen, arbeiten Data Scientists von Google beispielsweise schon an einem Modell namens Gemini (basierend auf dem Vorgänger Gato). Dieses soll alle Modalitäten verstehen – also Text und (bewegte) Bilder.

Das heißt zusammengefasst: Es bleibt spannend im Feld von generativer KI.

Bleib dran und abonniere deinen Tech-Newsletter.