So geht´s mit dem eigenen GPT-Chatbot in die Cloud

Du möchtest einen KI-basierten Chatbot sicher, datenschutzkonform und „privat“ in deinem Unternehmen nutzen? Mit Azure macht beispielsweise Microsoft das Cloud-Hosting eines eigenen GPT-Chatbots möglich. Wir zeigen dir an diesem Beispiel, wie es geht.

Die transformativen Auswirkungen, die generative KI wie ChatGPT und andere große Sprachmodelle (Large Language Models, LLMs) auf Unternehmen haben, sind gewaltig: Sie können die Produktivität verbessern, Kreativität steigern und bei alltäglichen Aufgaben unterstützen.

ChatGPT als eigene Enterprise-KI?

Aber bei allen Vorteilen gilt: Die Nutzung der öffentlich verfügbaren Technologie birgt für Unternehmen auch Risiken. Vor allem die Themen Compliance und der Schutz der eigenen Daten spielen hier eine Rolle. Und so gibt es gute Gründe, dass Unternehmen ihre eigenen, individuell angepassten GPT-Chatbots implementieren: Funktionen, die auf spezifische Branchenanforderungen zugeschnitten sind, Datensicherheit und Datenschutz, Skalierbarkeit und umfassende Kontrolle sind nur einige davon.

Dabei wird der private Chatbot über den Azure OpenAI Service realisiert: Microsoft bietet hier einen REST-API-Zugang zu den leistungsstarken Sprachmodellen von OpenAI an, darunter GPT-4, GPT-4 Turbo mit Vision, GPT-3.5-Turbo und Embeddings.

Auch andere Cloudanbieter ermöglichen es, KI-basierte Chatbots in die Cloud zu integrieren. So lassen sich über Amazon Bedrock bspw. Bots einführen, die auf den Modellen Llama 2 (Meta) oder Titan (Amazon) aufbauen.

Vorteile nutzen, geistiges Eigentum schützen

Das eigene geistige Eigentum bleibt damit geschützt: Denn alle Daten und Prompts laufen über den privaten Zugang und bleiben ausschließlich in der eigenen Azure Umgebung. Dabei besagt die Azure OpenAI Datenschutzrichtlinie ausdrücklich, dass weder Nutzer:innendaten geteilt noch zum Trainieren zukünftiger OpenAI Modelle verwendet werden.

Bedeutet: Mit Azure OpenAI erhältst du die Sicherheitsfunktionen von Microsoft Azure, während du gleichzeitig die Sprachmodelle von OpenAI für deine unternehmensspezifischen Use Cases nutzt .

Zusätzlich behältst du die Kontrolle darüber, wo der Service gehostet wird. Denn Azure OpenAI lässt sich so konfigurieren, dass die Daten innerhalb der EU und der eigenen Infrastruktur gespeichert werden, was vor allem hinsichtlich der GDPR (General Data Protection Regulation) wichtig ist.

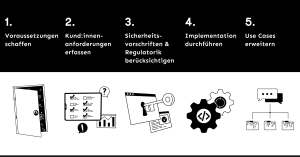

So geht´s mit ChatGPT in die Azure Cloud

1. Voraussetzungen schaffen

Die grundlegenden Voraussetzungen für den Betrieb des eigenen GPT-Chatbots sind ein Azure Konto und der Zugang zu OpenAI in diesem Konto, der zunächst beantragt werden muss.

Dabei haben Unternehmen, die bereits Azure nutzen, einen Vorsprung. Wenn es jedoch um die Anfrage an OpenAI geht, sind die Kapazitäten für alle (noch) begrenzt. Dazu sollte man bereits hier seinen Use Case kennen, da dieser im Antragsformular mit angegeben werden muss.

2. Kund:innenanforderungen erfassen

Wer einen maßgefertigten GPT-Chatbot über Azure OpenAI implementieren möchte, muss sich über seine Anforderungen im Klaren sein. Die zentrale Frage lautet: Welche Use Cases möchte ich mit welchen Services bei welchem Cloud-Provider implementieren? Bleibe ich vollständig bei Azure oder nutze ich noch andere Services, die z. B. bei AWS oder woanders gehostet sind? So lässt sich etwa das Web-Frontend auch über einen anderen Anbieter realisieren, während Azure als Schnittstelle zu OpenAI genutzt wird.

Anhand der Antworten wird die zugrundeliegende Infrastruktur mitsamt Ressourcen geplant, die über Azure oder einen anderen Anbieter bereitstehen sollen. Dazu gehören z. B. virtuelle Maschinen (VMs), Storage, Netzwerkdienste und weitere Services, die für den unternehmensspezifischen Betrieb von ChatGPT erforderlich sind.

3. Sicherheitsvorschriften & Regulatorik berücksichtigen

Nun gilt es, Themen wie das private Networking, die Authentifizierung der Endnutzer:innen, Datenverschlüsselung und die Frage des GPT-Standorts abzustimmen. Am Ende muss die Infrastruktur-Technologie mit ihren Funktionen alle Sicherheitsvorschriften und Regularien erfüllen.

Ideal ist es, wenn man ein bereits vorhandenes on-prem Active Directory mit Entra ID synchronisieren und Azure selbst als Log-in-Authentificator nutzen kann.

Ein weiteres Thema sind die benötigten Rechenkapazitäten: Eine Datacenter-Infrastruktur mit ausreichender GPU-Rechenpower gibt es derzeit in Deutschland nicht. So muss man auf Rechenzentren in den Niederlanden oder Schweden ausweichen, was die Implementation (vor allem hinsichtlich des Networkings) nochmals deutlich komplexer macht.

4. Implementation durchführen

Die vorab ausdefinierte Architektur wird nun umgesetzt. Dabei gilt es, ein Backend zu entwickeln, das die OpenAI API verwendet. Und natürlich braucht es auch ein Frontend, das die visuelle Schnittstelle zwischen ChatGPT und den Endnutzenden bildet.

Dabei leitet sich die Technologieauswahl aus den Kundenanforderungen ab. Für das Backend haben wir z. B. bereits das Python-Web-Framework FastAPI eingesetzt. Um hingegen den gewünschten „Endzustand“ einer Cloud- oder lokalen Infrastruktur für die Ausführung der ChatGPT-App zu beschreiben, hat uns Terraform gute Dienste geleistet.

Letztendlich gilt es, alle Komponenten wie Zahnräder miteinander zu vereinen, um den eigenen Chatbot für die private Nutzung startbereit zu machen.

5. Use Cases erweitern

Geschafft: Der private GPT-Chatbot ermöglicht die Nutzung generativer KI, bei der dein Unternehmen die volle Kontrolle über den Schutz und Standort der eigenen Daten behält. Zusätzlich ist das Feintuning des Sprachmodells mittels eigener Betriebsdaten für spezifische Anwendungen möglich. Etwa, um mit internen Dokumenten zu chatten oder eine KI-basierte Suche über Azure AI Search durchzuführen.

Die Implementierung eines eigenen KI-Chatbots in die Cloud erfordert eine sorgfältige Planung und birgt einige Herausforderungen. Doch: Richtig umgesetzt, ergeben sich zahlreiche Vorteile – insbesondere in puncto Sicherheit und Datenschutz. Wenn du das Potenzial eines eigenen privaten Chatbots für dein Unternehmen ausloten möchtest, kannst du auf unsere Expertise zählen.